Sursă foto: https://medium.com/

Introducere

Inteligența artificială (AI) avansează rapid, iar modelele mari de limbaj devin tot mai complexe.

Pentru a îmbunătăți eficiența și performanța AI, cercetătorii au dezvoltat Arhitectura Mixture-of-Experts (MoE).

Această metodă optimizează utilizarea resurselor, reducând costurile computaționale și îmbunătățind viteza de procesare.

MoE este utilizată de companii precum Google, OpenAI și DeepSeek pentru a construi modele AI avansate.

În acest articol, vom explora conceptul MoE, avantajele sale și impactul asupra viitorului AI.

1. Ce este arhitectura Mixture-of-Experts?

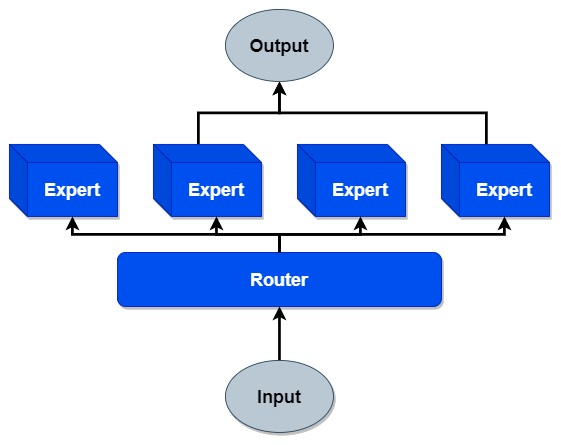

MoE este o tehnică avansată de învățare automată care împarte un model AI în mai multe sub-rețele specializate.

Aceste sub-rețele sunt numite „experți”, fiecare fiind responsabil pentru anumite tipuri de sarcini.

Un mecanism numit „gating network” decide care experți sunt activați pentru fiecare input.

Astfel, modelul nu folosește toți parametrii simultan, economisind resurse computaționale.

Această metodă permite scalarea AI fără a crește exponențial costurile de antrenare și inferență.

2. Cum funcționează?

Arhitectura Mixture-of-Experts utilizează mai multe componente pentru a îmbunătăți eficiența modelului AI.

1. Experții specializați

- Fiecare expert este o rețea neuronală separată, antrenată pentru sarcini specifice.

- Experții pot avea dimensiuni diferite, în funcție de complexitatea modelului.

2. Rețeaua de control (Gating Network)

- Decide care experți sunt activați pentru fiecare input.

- Atribuie un scor de relevanță fiecărui expert, alegând cei mai potriviți.

3. Activarea parțială a modelului

- În loc să activeze toți parametrii, MoE utilizează doar o mică parte a modelului per input.

- Acest proces reduce consumul de energie și accelerează procesarea.

Acest sistem asigură că modelul AI folosește eficient resursele disponibile.

3. Avantajele acestei arhitecturi

MoE oferă numeroase beneficii în comparație cu modelele tradiționale de AI.

1. Eficiență computațională

- Reduce utilizarea GPU-urilor și a memoriei RAM în timpul antrenamentului și inferenței.

- Poate rula modele mai mari pe hardware mai puțin performant.

2. Scalabilitate ridicată

- Modelele pot avea miliarde de parametri fără a crește proporțional costurile.

- Google și DeepSeek folosesc MoE pentru a crea modele AI extrem de mari.

3. Performanță îmbunătățită

- Selectarea experților potriviți pentru fiecare input îmbunătățește precizia modelului.

- Reduce erorile și face modelul mai adaptabil la sarcini diverse.

4. Flexibilitate în antrenare

- Modelele pot fi antrenate eficient pe seturi de date variate.

- Permite ajustarea rețelelor fără a modifica întreaga arhitectură.

Datorită acestor avantaje, MoE devine o soluție populară pentru modelele de AI avansate.

4. Dezavantajele arhitecturii

Deși MoE aduce numeroase beneficii, există și unele provocări tehnice.

1. Complexitatea implementării

- Necesită algoritmi avansați pentru distribuirea eficientă a sarcinilor între experți.

- Rețeaua de control trebuie optimizată pentru a preveni activarea excesivă a unor experți.

2. Dificultăți în distribuirea datelor

- Antrenarea unui model MoE pe mai multe GPU-uri necesită o sincronizare precisă.

- Comunicarea între experți poate deveni un obstacol în timpul procesării datelor.

3. Consum crescut de memorie

- Chiar dacă această arhitectură reduce utilizarea resurselor pe termen scurt, modelele mari necesită memorie suplimentară.

- Stocarea tuturor experților într-un singur model poate necesita servere puternice.

În ciuda acestor limitări, MoE rămâne o tehnologie promițătoare pentru viitorul AI.

5. Aplicații în AI

Această arhitectură este utilizată în mai multe domenii ale inteligenței artificiale.

1. Modele de limbaj (LLMs)

- GPT-4, DeepSeek-V3 și Google Switch Transformer folosesc MoE pentru eficiență crescută.

- Aceste modele procesează volume mari de text fără a consuma resurse excesive.

2. Recunoaștere a imaginilor

- Arhitectura este utilizată pentru clasificarea și analiza imaginilor complexe.

- Îmbunătățește precizia recunoașterii obiectelor și a fețelor umane.

3. Asistenți virtuali și chatbot-uri

- Permite crearea de chatbot-uri mai inteligente și mai eficiente.

- Experții sunt activați în funcție de contextul conversației.

4. Traducere automată

- MoE optimizează modelele de traducere neurală, oferind rezultate mai precise.

- Poate adapta traducerile la dialecte și expresii regionale.

Aceste aplicații demonstrează impactul pozitiv al MoE asupra AI-ului modern.

6. Viitorul arhitecturii MoE

Pe măsură ce AI evoluează, MoE va deveni o tehnologie esențială pentru modele scalabile.

1. Dezvoltarea unor modele mai eficiente

- Cercetătorii vor îmbunătăți algoritmii MoE pentru a reduce consumul de memorie.

- Modelele vor deveni mai rapide și mai ușor de utilizat pe dispozitive mobile.

2. Extinderea în domenii noi

- MoE ar putea fi aplicat în robotică, analiză financiară și medicină.

- Modelele AI vor putea oferi soluții personalizate pe scară largă.

3. Democratizarea AI

- Modelele MoE open-source vor permite accesul mai larg la inteligența artificială avansată.

- Companiile mici vor putea utiliza AI performant fără costuri uriașe.

Cu aceste îmbunătățiri, MoE ar putea deveni standardul pentru AI-ul viitorului.

Concluzie

Arhitectura Mixture-of-Experts (MoE) este o inovație care schimbă fundamental modul în care AI este antrenat și utilizat.

Aceasta permite scalabilitate ridicată, eficiență computațională și performanță superioară, făcând-o ideală pentru modelele de inteligență artificială moderne.

În ciuda provocărilor tehnice, MoE reprezintă o soluție viabilă pentru viitorul AI.

Pe măsură ce tehnologia evoluează, MoE va deveni din ce în ce mai utilizată în industrie.

Acest progres va conduce la modele AI mai rapide, mai eficiente și mai accesibile pentru toată lumea.